L’Adaptation de Basse Rangée (LoRA) et La Quantification dans l’Optimisation des Modèles IA

L’intelligence artificielle (IA) transforme les industries en offrant des solutions plus efficaces et évolutives. Deux techniques essentielles qui favorisent ces avancées sont l’Adaptation de Basse Rangée (LoRA) et la quantification. Ces méthodes rationalisent les exigences computationnelles et de mémoire des grands modèles d’IA, améliorant ainsi leur accessibilité et leur efficacité sans compromettre les performances.

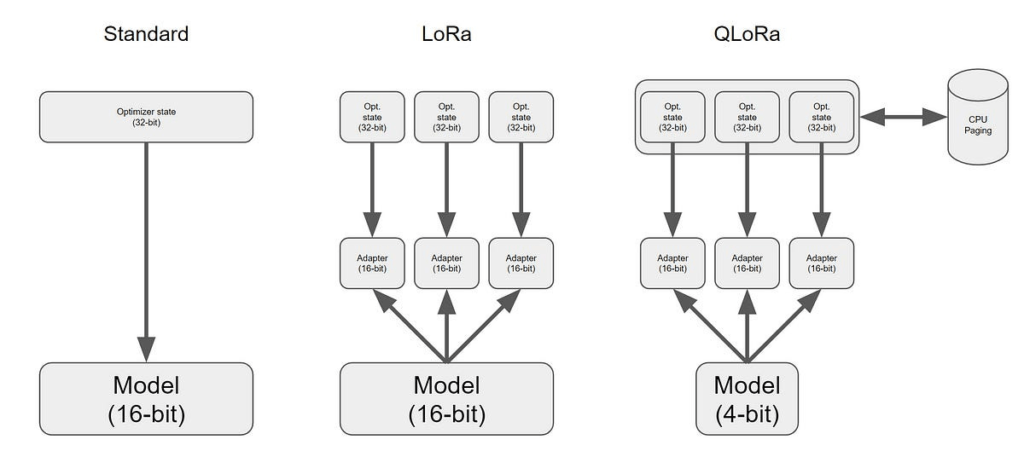

LoRA affine le processus de fine-tuning (mise au point) des grands modèles de langage (LLMs) en incorporant des matrices de basse rangée, réduisant ainsi considérablement le nombre de paramètres à ajuster. Parallèlement, la quantification réduit la précision des calculs numériques, ce qui se traduit par une inférence plus rapide et une réduction de l’utilisation de la mémoire.

Cet article explore les mécanismes, les applications et les avantages de ces techniques transformatrices, et introduit l’Adaptation de Basse Rangée Quantification-Aware (QA-LoRA), qui combine les avantages des deux approches.

L’Adaptation de Basse Rangée (LoRA) (Low-Rank Adaptation)

Qu’est-ce que LoRA ?

L’Adaptation de Basse Rangée (LoRA) est une technique conçue pour optimiser la mise au point (fine-tuning) des grands modèles de langage (LLMs) en réduisant le nombre de paramètres ajustables. Cela est réalisé en incorporant des matrices de basse rangée dans le modèle, permettant des mises à jour significatives avec un minimum de ressources computationnelles.

Comment fonctionne LoRA ?

LoRA utilise le concept de matrices de basse rangée pour adapter efficacement les grands modèles. Au lieu de mettre à jour tous les paramètres d’un modèle, LoRA introduit des matrices de basse rangée ajustables (généralement représentées par AAA et BBB) qui modifient un sous-ensemble plus petit des paramètres du modèle. Cette approche réduit considérablement le nombre de paramètres à ajuster. Par exemple, dans le cas de GPT-3, LoRA peut réduire les paramètres ajustables de 175 milliards à seulement 17,5 millions (Mastering Low-Rank Adaptation (LoRA) (MS Cloud & Tech) (ar5iv).

Le processus implique la décomposition d’une grande matrice de poids W en deux matrices plus petites A et B. Pendant l’entraînement, les poids du modèle pré-entraîné sont figés, et seuls les paramètres de ces matrices de basse rangée sont mis à jour. Ce processus permet de préserver la structure de base et les connaissances intégrées dans le modèle pré-entraîné tout en l’adaptant à de nouvelles tâches (RunAI).

Applications et avantages

- Efficacité : LoRA réduit considérablement la charge computationnelle, permettant une adaptation plus rapide des modèles même sur du matériel moins puissant.

- Préservation des connaissances : En gardant intacts les poids de base, LoRA maintient les capacités et la compréhension originales du modèle pré-entraîné tout en permettant des adaptations spécifiques aux tâches.

- Polyvalence : LoRA peut être appliqué à divers modèles, y compris ceux utilisés dans le traitement du langage naturel (NLP) et la génération d’images. Par exemple, il a été utilisé dans les modèles de Diffusion Stable pour adapter des styles et des personnages sans besoin de réentraînement complet (Navan AI) (ar5iv).

La Quantification (Quantization)

Qu’est-ce que la quantification ?

La quantification est une technique visant à améliorer l’efficacité des modèles d’IA en réduisant la précision des valeurs numériques utilisées dans les calculs. Cela implique la conversion des poids de haute précision (comme les nombres flottants 32 bits) en formats de précision inférieure (comme les entiers 8 bits).

Comment fonctionne la quantification ?

La quantification consiste à mapper une grande gamme de valeurs continues à un ensemble plus restreint de valeurs discrètes. Ce processus réduit considérablement l’empreinte mémoire et accélère le processus d’inférence. Des techniques comme QLoRA combinent la quantification avec LoRA pour améliorer les performances du modèle tout en maintenant l’efficacité. Cette approche est cruciale pour déployer des modèles d’IA sur des appareils à ressources limitées, comme les dispositifs périphériques.

Applications et avantages de la Quantification

- Réduction de l’utilisation de la mémoire : En abaissant la précision des poids, la quantification diminue considérablement la mémoire nécessaire pour stocker les paramètres du modèle.

- Inférence plus rapide : Les opérations arithmétiques plus simples des calculs à faible précision rendent les modèles quantifiés idéaux pour les applications en temps réel.

- Efficacité énergétique : En réduisant la charge computationnelle, la quantification diminue la consommation d’énergie, ce qui est bénéfique pour les dispositifs alimentés par batterie.

- Large applicabilité : La quantification peut être appliquée à divers modèles, les rendant adaptés à une large gamme d’applications sur différentes plateformes.

QA-LoRA: Fine-Tuning Sensible à la Quantification

QA-LoRA étend le concept de LoRA en intégrant la quantification dans le processus de mise au point (fine-tuning). Cette approche, appelée Quantization-Aware LoRA (QA-LoRA), ajuste et quantifie simultanément les paramètres du modèle. Ce processus conjoint réduit non seulement le coût en mémoire, mais accélère également le fine-tuning. La méthode utilise des types de données INT4 pour la quantification, contrairement à QLoRA qui utilise NF4, ce qui peut conduire à de meilleures performances et à une perplexité inférieure (Sebastian Raschka, PhD) (RunAI).

Comment fonctionne QA-LoRA

QA-LoRA intègre la formation consciente de la quantification avec l’adaptation de basse rangée. Dans LoRA traditionnel, les matrices de basse rangée AAA et BBB sont introduites pour réduire le nombre de paramètres ajustables. QA-LoRA va plus loin en incorporant la quantification directement dans la phase de fine-tuning. Cela signifie que les matrices de basse rangée et les paramètres de quantification sont optimisés ensemble pendant l’entraînement (Sebastian Raschka, PhD) (RunAI).

En termes pratiques, QA-LoRA modifie les poids du modèle de base en un format de précision inférieure, comme INT4, ce qui réduit drastiquement l’utilisation de la mémoire et les exigences computationnelles. Pendant le fine-tuning, les matrices de basse rangée ajoutées sont également quantifiées. Cette approche d’optimisation double garantit que le processus de fine-tuning est hautement efficace et que le modèle résultant reste léger et rapide pour l’inférence (RunAI).

Avantages de QA-LoRA

- Efficacité en mémoire : En réduisant la précision des paramètres du modèle, QA-LoRA diminue significativement l’empreinte mémoire. Cela est particulièrement bénéfique pour le déploiement de grands modèles de langage sur du matériel grand public avec une VRAM limitée, comme les GPU ayant moins de 24 Go de mémoire (Sebastian Raschka, PhD).

- Vitesse : Le processus combiné de quantification et de fine-tuning accélère l’adaptation des modèles à des tâches spécifiques. Cela est crucial pour les applications nécessitant des mises à jour régulières ou celles qui fonctionnent sur des ensembles de données en évolution rapide (RunAI).

- Performance : Malgré la précision réduite, QA-LoRA maintient des performances élevées. En utilisant les types de données INT4, QA-LoRA obtient souvent de meilleurs scores de perplexité par rapport aux méthodes comme QLoRA qui utilisent NF4 pour la quantification. Cela conduit à des modèles qui sont non seulement efficaces mais aussi performants pour fournir des résultats de haute qualité (Sebastian Raschka, PhD) (RunAI).

Comparaison avec QLoRA

QLoRA est une autre technique qui ajuste les modèles en utilisant LoRA sur des modèles de base quantifiés. Cependant, QLoRA utilise généralement NF4 pour la quantification, ce qui, bien qu’efficace, peut introduire des complexités en termes de vitesse d’inférence et de performance. NF4, étant une représentation compressée des nombres flottants, peut ne pas être aussi optimisée pour les calculs rapides que INT4 (Sebastian Raschka, PhD).

QA-LoRA aborde certaines des limitations de QLoRA en :

- Utilisant la quantification INT4, qui est plus simple et souvent plus rapide que NF4.

- Permettant à l’ensemble du modèle, y compris les matrices de basse rangée, d’être quantifié simultanément, ce qui simplifie les phases de déploiement et d’inférence.

- Atteignant des performances comparables ou meilleures avec une stratégie de quantification plus simple et plus efficace (Sebastian Raschka, PhD) (RunAI).

Mise en œuvre pratique et défis

La mise en œuvre de QA-LoRA implique plusieurs étapes, y compris l’initialisation des matrices de basse rangée, la configuration des paramètres de quantification et l’assurance de la stabilité pendant l’entraînement. Un défi pratique est la gestion du compromis entre la précision de la quantification et la performance du modèle.

Bien que la précision inférieure (comme INT4) réduise la charge mémoire et computationnelle, elle peut également risquer de perdre en précision du modèle. QA-LoRA aborde cela en équilibrant soigneusement la précision des différentes parties du modèle, garantissant des performances optimales sans dégradation significative (Sebastian Raschka, PhD).

En résumé, QA-LoRA offre une solution robuste pour le fine-tuning et le déploiement efficaces des grands modèles de langage. En combinant les forces de LoRA et de la quantification, il fournit une approche évolutive et performante pour adapter les systèmes d’IA à diverses applications. Cela en fait un outil précieux pour les développeurs et les chercheurs visant à optimiser les systèmes d’IA dans des environnements computationnels restreints.

Pousser les Limites de l’IA avec L’adaptation de Basse Rangée (LoRA) et la Quantification

LoRA et la quantification sont des techniques transformatrices dans le domaine de l’IA, répondant aux défis critiques de l’efficacité, de l’évolutivité et de la performance dans les grands modèles de langage. En réduisant de manière significative la surcharge computationnelle et mémoire requise pour l’entraînement et le déploiement des modèles d’IA, ces méthodes rendent les capacités avancées de l’IA accessibles même sur du matériel limité. QA-LoRA, l’intégration de la quantification avec LoRA, va encore plus loin en affinant et en quantifiant simultanément, garantissant des performances élevées tout en maintenant une faible consommation de ressources.

À mesure que l’IA continue de progresser, l’adoption de techniques comme LoRA et la quantification sera cruciale pour repousser les limites de ce que l’IA peut accomplir, favorisant l’innovation dans divers secteurs et applications.